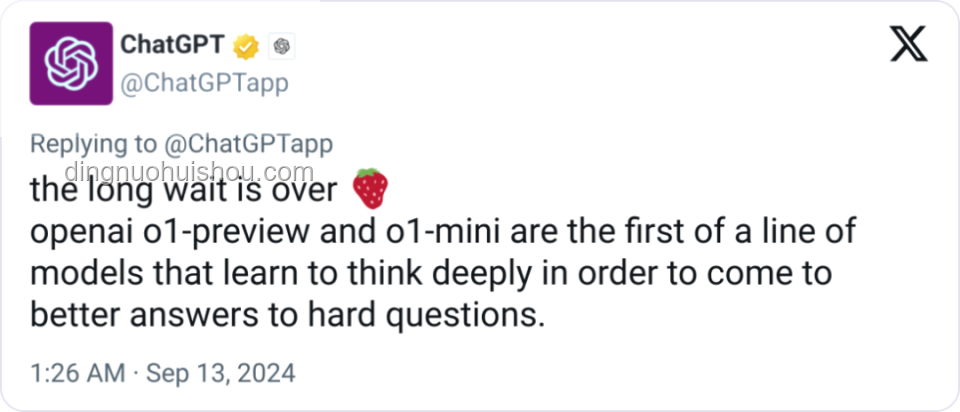

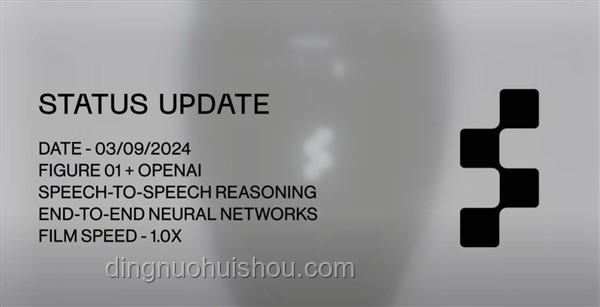

启程:初识o1 self-play RL的魅力

一切始于对OpenAI那份无尽的好奇与向往。在AI的世界里,self-play(自我对弈)和强化学习(RL)的结合,仿佛打开了一扇通往未知世界的大门。o1,作为OpenAI探索强化学习新边界的里程碑项目,其背后的技术路线深深吸引了我——通过智能体在与自身的不断博弈中,学会策略优化,最终实现超人类的水平。🤔

初尝甜头:构建基础框架

搭建环境

我的第一步是从搭建self-play的环境开始。选择了一个简单的棋类游戏作为起点,利用Python和PyTorch库,我着手构建了一个能够自我对弈的基础框架。这个过程充满了挑战,从环境设计到智能体状态空间、动作空间的定义,每一步都需要精心考量。🧩

初步训练

随着环境的搭建完成,我迫不及待地将一个简单的Q-learning算法应用到了智能体上。起初,智能体的表现笨拙而可笑,但它每一次失败后的调整,都像是在向成功迈进的一小步。通过观察智能体自我对弈的过程,我逐渐理解了self-play的精髓——在不断试错中学习,从失败中成长。🌱

挫折与反思:深度探索的坎坷

策略瓶颈

然而,随着训练的深入,我遇到了第一个瓶颈:智能体的策略似乎陷入了局部最优,难以进一步提升。这时,我意识到,单纯的Q-learning已经无法满足复杂策略的学习需求。我开始研究更高级的强化学习算法,如PPO(Proximal Policy Optimization)和A3C(Asynchronous Advantage Actor-Critic),并尝试将它们应用到self-play框架中。🔍

失败与调整

调整算法的过程并不顺利,新算法带来了更高的计算成本,而且智能体的表现一度出现了倒退。那段时间,我几乎每天都在与代码和算法斗争,深夜的灯光下,我反复思考着问题的根源。最终,通过优化网络结构、调整学习率和奖励函数,智能体的表现开始稳步提升,那一刻的喜悦无以言表。🎉

突破与成长:技术路线的深化

深度自我对弈

随着算法的优化,我引入了深度自我对弈的概念,让智能体在与不同历史版本的自己对弈中,不断学习和进化。这一过程不仅提升了智能体的策略多样性,还使其在面对未知对手时更加灵活应变。🌟

创新与融合

在探索的过程中,我不断尝试将其他领域的先进技术融入self-play框架,如注意力机制、迁移学习和多智能体协作。这些创新不仅丰富了智能体的能力,也让我深刻体会到跨学科融合对于AI研究的重要性。🌐

心得体会:一场智能与自我的对话

自我挑战的乐趣

回望这段旅程,self-play不仅仅是一种技术路线,更是一种自我挑战的精神体现。每一次智能体的进步,都是对自己认知边界的拓宽,让我深刻体会到“教然后知困,学然后知不足”的道理。📚

情感的共鸣

在智能体不断进化的过程中,我仿佛看到了自己的成长轨迹。从最初的迷茫到后来的坚定,从失败中的沮丧到成功后的喜悦,这些情感的共鸣,让这次探险之旅更加难忘。💖

给未来探索者的建议

- 勇于尝试:不要害怕失败,每一次尝试都是向成功迈进的一步。

- 持续学习:AI领域日新月异,保持好奇心和学习力是关键。

- 跨学科融合:跨界思考往往能带来意想不到的突破。

- 享受过程:享受每一次与智能体共舞的瞬间,那是成长的见证。 Q&A Q: self-play RL技术适用于哪些领域? A: 自我对弈强化学习技术广泛应用于游戏AI、自动驾驶、机器人控制等领域,特别是在需要高度策略性和自适应能力的场景中。 Q: 如何克服智能体策略陷入局部最优的问题? A: 可以通过引入多样性策略、使用更先进的强化学习算法、增加探索噪声等方法来避免策略陷入局部最优。 在这场智能进化的探险之旅中,我学会了坚持与创新,体验了失败与成功,更重要的是,我找到了与智能体共同成长的乐趣。愿每一位AI探索者都能在各自的旅途中,收获属于自己的星光。✨

文章评论 (4)

发表评论