案例背景

近年来,随着人工智能技术的飞速发展,大语言模型(LLM)在自然语言处理领域取得了诸多突破。然而,传统的LLM训练方法,如行为克隆(Behavior Clone)和基于人类反馈的强化学习(RLHF),在面对复杂推理任务时仍显不足。在此背景下,OpenAI推出了全新的o1模型,该模型通过self-play RL技术路线,在数理推理等领域取得了傲人的成绩,为LLM的训练和应用开辟了新的道路。

面临的挑战/问题

传统LLM训练方法的局限性主要体现在以下几个方面:

- 数据依赖性强:传统的行为克隆方法依赖于大规模语料库,但互联网上可用的高质量语料已近乎枯竭,限制了模型的进一步提升。

- 推理能力不足:尽管RLHF方法通过引入正负例反馈提升了模型的偏好对齐能力,但在复杂推理任务上仍显捉襟见肘。

- 训练效率低下:传统的训练方法往往需要大量的训练数据和时间,成本高昂,且难以充分利用负例数据提升推理强度。

采用的策略/方法

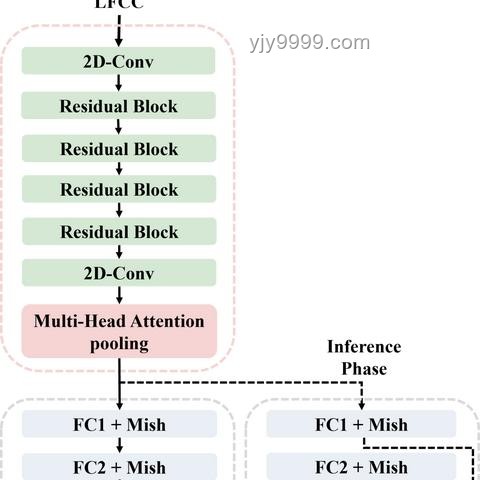

针对上述挑战,OpenAI采用了self-play RL技术路线来训练o1模型。Self-play是一种通过模型自我对弈或博弈来实现进化的方法,它引入了Generator和Verifier两个关键组件,通过对抗博弈的方式提升模型的推理能力。

Self-Play RL的核心组件

- Generator:负责生成推理过程和结果。

- Verifier:对Generator生成的推理过程和结果进行判定,构造高质量数据用于RL/Reward训练。

实施的Scaling Law

OpenAI在o1模型中提出了两个全新的RL scaling law:train-time compute和test-time compute。

- Train-time compute:在训练阶段,通过增加强化学习的计算量来提升模型性能。

- Test-time compute:在推理阶段,通过增加思考时间来提升模型的推理能力。这一策略允许模型在回答问题之前进行长时间的内部思考,逐步提出假设、验证思路并反思,从而实现深度推理。

实施过程与细节

技术路线推演

OpenAI的o1模型采用了全新的多模态Self-play RL技术路线。在训练过程中,模型通过自我对弈的方式不断生成正负例数据,并利用这些数据进行强化学习。同时,模型在推理阶段会进行长时间的思考,通过逐步提出假设、验证思路并反思来实现深度推理。

具体实施步骤

- 数据生成:利用Generator组件生成大量的推理过程和结果。

- 数据判定:利用Verifier组件对生成的推理过程和结果进行判定,构造高质量的正负例数据。

- 强化学习:利用构造的正负例数据进行强化学习,提升模型的推理能力。

- 推理阶段思考:在推理阶段,模型会进行长时间的内部思考,通过逐步提出假设、验证思路并反思来实现深度推理。

结果与成效评估

OpenAI o1模型在数理推理领域取得了显著的成绩。通过self-play RL技术路线,模型不仅提升了推理能力,还提出了全新的RL scaling law,为LLM的训练和应用提供了新的思路。

成效展示

- 推理能力提升:o1模型在各类数理类benchmark上的表现优于传统方法。

- Scaling Law验证:实验结果表明,train-time compute和test-time compute两个全新的RL scaling law在o1模型中得到了有效验证。

- 多模态能力保持:尽管o1模型在语言层面的Reasoning能力得到了显著提升,但其他模态的能力并未因此牺牲。

经验总结与启示

OpenAI o1模型的成功经验为我们提供了以下启示:

- Self-Play RL的潜力:Self-play RL技术路线在大语言模型训练中具有巨大潜力,通过模型自我对弈或博弈的方式可以实现推理能力的显著提升。

- Scaling Law的重要性:提出并验证新的RL scaling law对于提升模型性能至关重要。在o1模型中,train-time compute和test-time compute两个全新的scaling law为模型性能的提升提供了有力支持。

- 多模态能力的平衡:在提升某一模态能力的同时,需要保持其他模态能力的平衡,以确保模型的全面性和实用性。

可推广的启示

- 技术框架:OpenAI的self-play RL技术框架可以推广到其他领域的LLM训练中,特别是需要复杂推理能力的场景。

- Scaling Law应用:新的RL scaling law为LLM的训练提供了新的思路和方法,可以进一步探索和验证其他可能的scaling law以提升模型性能。 通过本案例研究,我们可以看到OpenAI o1模型通过self-play RL技术路线在数理推理领域取得了显著成绩。这一成功案例不仅为我们提供了宝贵的经验总结,还为LLM的训练和应用提供了新的思路和方法。未来,我们可以期待self-play RL技术在大语言模型领域发挥更大的作用。

文章评论 (4)

发表评论